Mele marce: iOS 15, la privacy personale e la lotta in corso contro la CSAM.

"iOS 15 In contatto. Nel momento".

Con questo nuovo aggiornamento del sistema operativo sembra che stiamo ottenendo tre nuove funzionalità che secondo Apple "aiuteranno a proteggere i bambini dai predatori che utilizzano strumenti di comunicazione per reclutarli e sfruttarli, e limitare la diffusione di materiale pedopornografico (CSAM)". Il primo mira a migliorare la "Sicurezza delle comunicazioni in Messaggi" che aggiunge nuovi strumenti di controllo parentale e avvisi che appariranno quando viene inviato o ricevuto materiale sessualmente esplicito. La seconda è una funzione che utilizzerà un algoritmo di rilevamento CSAM per la scansione dell'app Foto per gli hash delle immagini che corrispondono agli hash conosciuti CSAM. La terza nuova funzione di protezione dei bambini introduce una "guida" di ricerca che fornisce agli utenti le risorse per segnalare CSAM e interverrà attivamente se gli utenti cercano un termine che è collegato al CSAM. Prendiamoci un momento e spacchettiamo i dettagli di ciò che queste caratteristiche mirano a fare e come lo fanno.

Niente più foto di cazzi non richiesti.

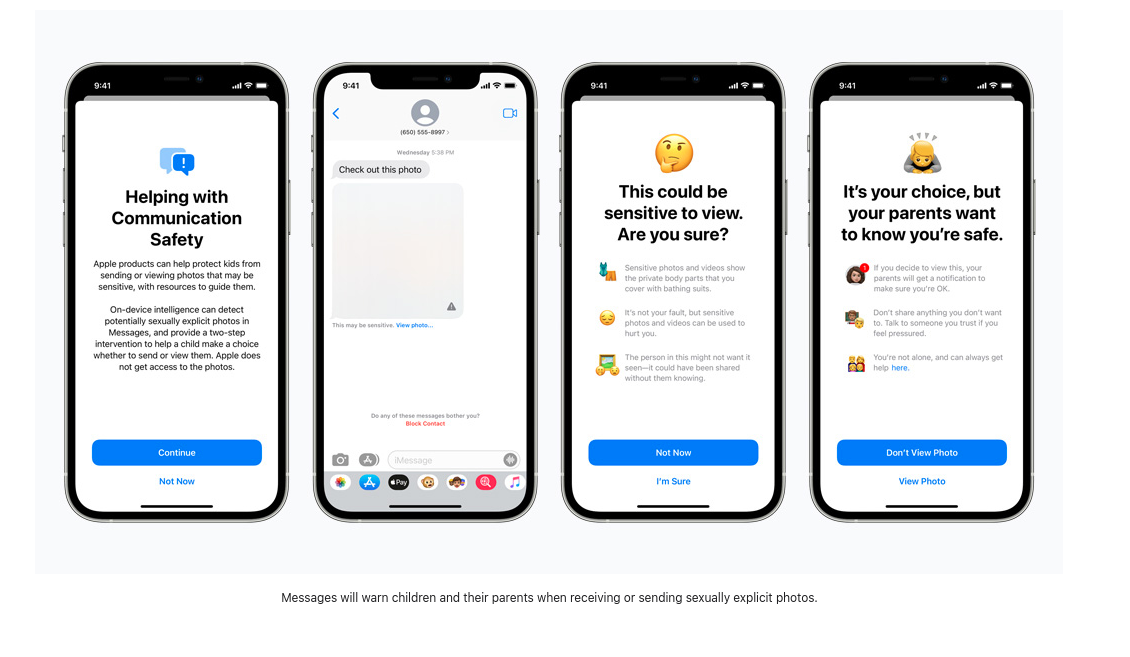

Un recente studio della Thorn riporta che "Il materiale di abuso sessuale su minori autogenerato (SG-CSAM) è un'area in rapida crescita del materiale di abuso sessuale su minori (CSAM) in circolazione online e consumato da comunità di abusatori". La nuova "Expanded Protections for Children" di Apple mira a rallentare la crescita di questa pratica. La condivisione di "nudi" tra partner romantici spesso si diffonde in un gruppo di pari e può finire online in casi di "revenge porn". Apple inizierà ora a presentare ai bambini (o agli utenti con queste funzioni di sicurezza abilitate) degli avvisi sulla visualizzazione o l'invio di immagini esplicite. Nel caso in cui un'immagine venga vista o inviata, il dispositivo del genitore riceverà un messaggio di notifica sull'attività.

Le immagini in arrivo vengono analizzate da un programma di apprendimento automatico sul dispositivo che segnala il materiale sospetto e "impara" a determinare se le immagini future rientrano nella stessa categoria. Chi controlla questo algoritmo e quale impatto gli utenti possono avere per influenzare il modo in cui segnala le immagini sospette rimane non rivelato. Apple scrive che questa "funzione è progettata in modo che Apple non abbia accesso ai messaggi", quindi con questo nuovo aggiornamento, Apple inizierà a vagliare i messaggi criptati che vengono inviati tramite iMessage, al fine di avvertire i genitori e gli adolescenti di comportamenti online dannosi.

In superficie questo potrebbe non sembrare pericoloso, ma se questa stessa tecnologia di scansione fosse impiegata per scansionare i messaggi criptati alla ricerca di opinioni politiche dissenzienti, lingue religiose minoritarie, o discussioni di orientamento sessuale, questo nuovo software di monitoraggio sul dispositivo potrebbe essere facilmente alterato e abusato.

Alcuni esempi di messaggi di avvertimento da https://www.apple.com/child-safety/

Alcuni esempi di messaggi di avvertimento da https://www.apple.com/child-safety/

Scansione per fermare la diffusione.

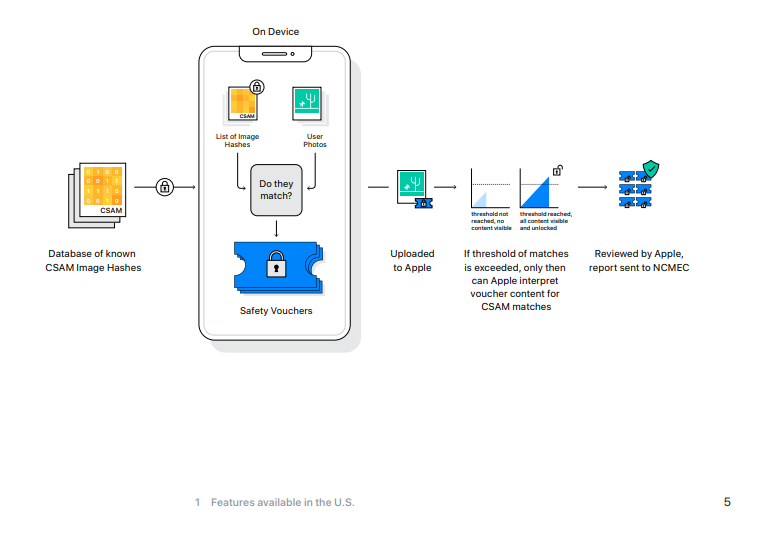

Secondo la Electronic Frontier Foundation, "anche se Apple detiene le chiavi per visualizzare le foto memorizzate in iCloud Photos, non scansiona queste immagini". Questo cambierà con iOS 15 e se state attualmente eseguendo il backup delle vostre foto in iCloud di Apple, queste foto saranno sottoposte ad hash e quei valori saranno confrontati con quelli di CSAM conosciuti.

Se un dispositivo iOS ha abilitato la funzione di backup di iCloud, questa scansione inizierà prima sulla macchina locale. Il nuovo iOS 15 include una versione del National Center for Missing and Exploited Children's CSAM hashed image database, e le immagini non criptate scattate su un iPhone avranno il loro hash (un *speriamo* unico valore numerico che rappresenta l'immagine) confrontato con quelli del database del NCMEC. Nel caso in cui ci sia una corrispondenza, le foto vengono inviate a revisori umani alla Apple. Se questi revisori possono confermare la corrispondenza, allora l'immagine viene inviata al NCMEC, alle forze dell'ordine, e l'account dell'utente viene disattivato.

Se stai usando iCloud per il backup delle tue foto, le tue foto saranno scansionate contro questo database, senza causa probabile o sospetto che tu possa aver commesso o essere coinvolto in qualsiasi crimine.

[Non guardare questa foto.

L'ultima nuova funzione di sicurezza per i bambini è un aggiornamento di Siri e Search che offrirà una guida su come segnalare casi di CSAM così come "intervenire" se gli utenti stanno cercando termini relativi a CSAM.

La lista esatta di parole non è pubblica e non sappiamo se i termini segnalati dagli utenti saranno utilizzati per addestrare il monitor di ricerca ad apprendimento automatico.

Ci sono pochissime informazioni disponibili sul tipo di termini che fanno scattare questi avvisi e cosa succede quando vengono ignorati. Nel caso della revisione dell'hashing delle immagini, un dipendente Apple determinerà i risultati corrispondenti, ma non sappiamo quali ulteriori misure vengono prese con i risultati della ricerca. Quando si visualizza la pagina stampa ufficiale di Apple per queste nuove funzionalità, la discussione sui termini di ricerca monitorati consiste in quattro brevi frasi. Sarà anche interessante vedere se questa lista cresce in base ai termini segnalati dagli utenti o come Apple sceglie di addestrare questo algoritmo.

Se non hai nulla da nascondere...

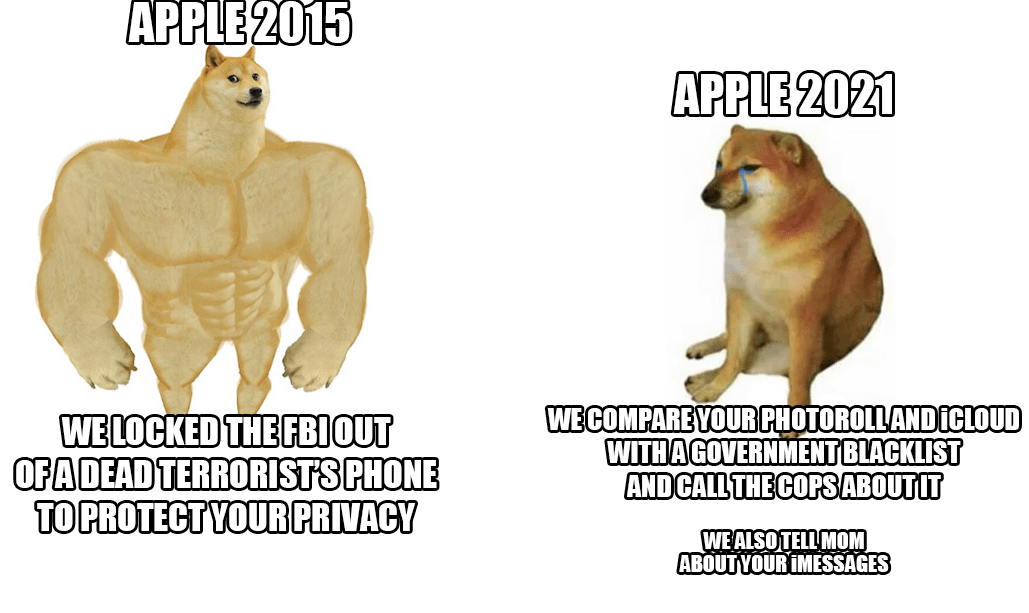

Tra queste tre nuove caratteristiche, gli utenti Apple e quelli che inviano messaggi e immagini con loro, sono sottoposti alla scansione dei loro messaggi criptati, al monitoraggio dei loro termini di ricerca privati, e tutto questo avviene senza alcun sospetto o prova di un crimine. Una cosa è che Apple e altre aziende Big Tech scannerizzino gli hash delle immagini memorizzate sui loro server. Dopo tutto, questi server sono di proprietà dell'azienda e non si è obbligati ad usarli. Ma spingere queste nuove funzioni di sorveglianza sui dispositivi locali ignora il fatto che tu, il proprietario del dispositivo, hai pagato centinaia di dollari (o euro) per un dispositivo che sta monitorando il tuo comportamento. Non avete molta scelta su quali processi stanno eseguendo un pezzo della vostra proprietà personale. Questo 'miglioramento' si allontana ancora di più dal modello di prodotto come servizio che è già diventato mainstream nel mondo del software proprietario.

Con questa nuova versione di iOS Apple sta minando la sicurezza della sua piattaforma di messaggistica, una volta lodata. Un'app di messaggistica crittografata Ende-zu-Ende che scansiona le immagini una volta che raggiungono il dispositivo di destinazione è una bugia pericolosa che non fa nulla per proteggere la sicurezza e la privacy degli utenti Apple. Come questo comportamento può essere applicato da stati nazionali che non rispettano i diritti umani è una ricetta per il disastro.

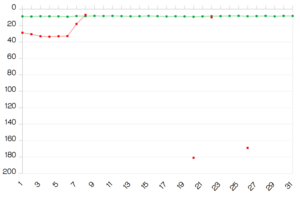

Edward Snowden sottolinea la strana evoluzione di Apple in un tweet del6 agosto 2021.

Edward Snowden sottolinea la strana evoluzione di Apple in un tweet del6 agosto 2021.

IOS 15 stabilisce uno standard pericoloso per il futuro della crittografia Ende-zu-Ende.

Proteggere i bambini sarà il mantra che ci porta in un mondo di maggiore sorveglianza e la dissoluzione della privacy personale. Sì, il CSAM è ripugnante e dovrebbe essere perseguito nella misura massima della legge, ma l'esistenza del CSAM non giustifica l'abbandono di una discussione sfumata che circonda la privacy, la crittografia dei dati, la violenza sessuale e la sorveglianza.

Matthew Green avverte delle conseguenze di questi cambiamenti scrivendo: "Indipendentemente da quali siano i piani a lungo termine di Apple, hanno inviato un segnale molto chiaro. Secondo la loro (molto influente) opinione, è sicuro costruire sistemi che scansionano i telefoni degli utenti per contenuti proibiti. Questo è il messaggio che stanno inviando ai governi, ai servizi concorrenti, alla Cina, a voi".