Fuite d'un document sur le "contrôle du chat" : L'Allemagne va-t-elle se battre pour le respect de la vie privée ?

Le gouvernement allemand a posé des questions difficiles à la Commission européenne sur son projet de loi sur la surveillance.

Des questions difficiles soulevées

Le projet de règlement de la Commission européenne visant à prévenir et à combattre la maltraitance des enfants constitue une attaque frontale contre les droits civils. Dans son projet de loi, la Commission européenne décrit l'un des appareils de surveillance de masse les plus sophistiqués jamais déployés en dehors de la Chine : L'analyse du matériel pédopornographique (CSAM) sur les appareils de tout un chacun.

Le gouvernement allemand, cependant, a convenu dans son document de coalition que chaque citoyen a un "droit au chiffrement"- ce qui serait évidemment remis en cause si le projet de la Commission européenne devenait une loi.

Dans une déclaration interne à la Commission européenne qui a fait l'objet d'une fuite, le gouvernement allemand exige que le projet de loi soit mis en conformité avec "les normes constitutionnelles de protection des communications privées et confidentielles". La déclaration se positionne contre "la surveillance générale et les mesures de balayage des communications privées".

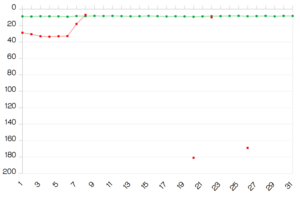

Selon la fuite, le gouvernement allemand pose 61 questions, qui sont en partie très difficiles et poseront de sérieux problèmes de réponse à la Commission européenne.

Par exemple, le gouvernement allemand demande explicitement si la référence à l'importance du cryptage de bout en bout dans le texte signifie également que ce cryptage ne doit pas être mis à mal lors de la détection d'images de violence sexuelle. En outre, le gouvernement allemand demande comment le projet de loi est compatible avec certaines dispositions du règlement général sur la protection des données (RGPD) ou si le logiciel peut être construit de manière à pouvoir distinguer les enfants dans des situations non abusives (par exemple à la plage) de ceux dans des situations abusives.

Une autre question importante touche à la question de la sécurité de tous les citoyens européens : Le gouvernement allemand demande comment la loi pourrait déterminer si la technologie ne sera pas utilisée à mauvais escient et comment elle déterminerait l'utilisation abusive.

Quelle sera la réponse de la Commission ?

En somme, le gouvernement allemand pose des questions critiques qui mettent en lumière toutes les faiblesses du projet de loi de la Commission européenne : La surveillance générale de masse telle que proposée par le projet de loi affaiblira la sécurité des citoyens et des entreprises européens et portera atteinte au droit à la vie privée.

Il faut s'attendre à ce que la Commission européenne ne puisse répondre à ces questions que de manière insatisfaisante. L'abondance et la profondeur des détails des questions posées par le gouvernement allemand, ainsi que les violations massives des droits fondamentaux par la proposition de loi, font qu'il est pratiquement impossible de répondre d'une manière qui puisse satisfaire les experts en protection des données.

Lutte pour la vie privée

La question qui doit être posée maintenant est la suivante : comment le gouvernement allemand va-t-il réagir lorsqu'il recevra les réponses peu satisfaisantes ? Va-t-il faire pression pour le "droit au cryptage", comme le prévoit le document de la coalition ? Défendra-t-il le droit à la vie privée de chaque citoyen européen ?

Bien que la fuite des questions soit un très bon signe, nous ne devons pas rester les bras croisés et attendre que les choses évoluent.

Au contraire, nous devons agir maintenant et dire aux politiciens que notre droit à la vie privée est important.

**Si vous vivez en Allemagne, signez la pétition de Campact**pour lutter contre le projet de la Commission européenne qui conduirait à une surveillance de masse sans précédent en Europe.

**Si vous vivez en Autriche, signez la pétition #aufstehn**pour lutter contre le projet de la Commission européenne qui conduirait à une surveillance de masse sans précédent en Europe.

**Faites part de vos réactions à**la Commission européenne et partagez vos préoccupations concernant ce projet de loi.

**Vérifiez ici**comment vous pouvez rejoindre la manifestation ainsi qu'appeler et envoyer des emails à vos représentants.

Ensemble, nous devons lutter contre la surveillance de masse !

Document ayant fait l'objet d'une fuite

Date : 10.06.2022 De : Gouvernement allemand Document : 206/2022

Questions allemandes sur la proposition de règlement du Parlement européen et du Conseil établissant des règles pour prévenir et combattre l'exploitation sexuelle des enfants (COM).

GER remercie la COM pour cette initiative et salue l'effort de la COM pour prévenir et combattre les abus sexuels sur les enfants. Ceci est également un objectif du traité de coalition. Le projet de règlement de la CSA est un pas important vers la lutte contre les abus sexuels sur les enfants dans l'espace numérique au niveau européen et vers une meilleure protection des enfants.

Une législation commune comprenant l'évaluation des risques, l'atténuation des risques, le signalement des risques, une base juridique claire et un nouveau centre européen peut contribuer à renforcer la prévention et la poursuite des abus sexuels sur les enfants dans toute l'UE - tout en reconnaissant les structures existantes des services de signalement des contenus.

La confidentialité des communications est un atout important dans nos sociétés libérales qui doit être protégé. Sur la base de la Charte des droits fondamentaux, chacun a droit au respect de sa vie privée et familiale, de son domicile et de ses communications. Toutes les mesures réglementaires doivent être proportionnées, ne doivent pas aller au-delà de ce qui est nécessaire pour prévenir les abus sexuels sur les enfants dans l'espace numérique, et doivent équilibrer efficacement les intérêts contradictoires de la protection des enfants contre les abus d'une part et de la protection de la vie privée d'autre part.

Le GER contribuera à trouver des moyens clairs, appropriés et permanents pour des mesures permettant de renforcer la prévention et la poursuite des abus sexuels sur les enfants dans toute l'UE. Selon le traité de coalition de GER, le secret des communications, un haut niveau de protection des données, un haut niveau de cybersécurité ainsi que le cryptage universel de bout en bout sont essentiels pour GER. Le traité de coalition du GER s'oppose aux mesures de surveillance générale et aux mesures d'analyse des communications privées. Le GER examine le projet de proposition à la lumière du traité de coalition. Pour le GER, il est important que la réglementation luttant contre et empêchant la diffusion de matériel pédopornographique soit conforme à nos normes constitutionnelles de protection des communications privées et confidentielles.

En ce qui concerne l'établissement d'un centre européen, la stratégie de l'UE prévoyait une approche plutôt globale de la prévention en ligne et hors ligne. La proposition actuelle semble soutenir principalement les activités répressives, sans mandat explicite pour les mesures de prévention hors ligne. De notre point de vue, le Centre de l'UE devrait également être une plaque tournante pour les mesures de sensibilisation et le soutien des réseaux (y compris les réseaux de survivants d'abus sexuels sur les enfants). Nous sommes convaincus que le Centre européen devrait se concentrer en particulier sur la prévention de la CSA en ligne. Cependant, dans le cadre de ses compétences, il devrait également se concentrer sur la CSA hors ligne, lorsque les délits en ligne sont associés à la violence hors ligne. De plus, le GER conseille de mettre en place une structure égale de participation active des personnes affectées par la CSA dès le début de la conception du Centre européen. Le Centre européen a pour objectif de fournir un soutien aux personnes touchées par la CSA. Cependant, la proposition actuelle ne fournit pas d'informations concernant la participation des personnes concernées par la CSA au Centre de l'UE.

Nonobstant ces commentaires de fond, nous continuons à examiner la proposition actuelle visant à établir le Centre de l'UE en tant qu'agence indépendante.

Notre réserve d'examen inclut également, mais pas seulement, la conception organisationnelle d'un nouveau Centre européen, l'article 4, et - de manière très générale - l'équilibre entre les droits fondamentaux, notamment en ce qui concerne la confidentialité des communications et le cryptage de bout en bout.

GER accueillerait très favorablement la possibilité d'organiser des ateliers techniques d'experts parallèlement au LEWP. Les ateliers techniques donneraient aux EM l'opportunité d'en savoir plus sur les technologies en jeu concernant les ordres de détection et aideraient à améliorer une compréhension commune au sein des EM.

Nous examinons attentivement le projet de règlement et nous le commenterons ultérieurement. A ce stade, le GER a de nombreuses questions. Nous tenons à remercier la Présidence et la COM pour l'opportunité de transmettre nos questions et nos premières observations.

Le GER demande des éclaircissements sur les questions suivantes. A ce stade, la priorité du GER réside dans les questions suivantes :

Comment la CSA de l'UE soutient-elle la prévention des abus sexuels d'enfants hors ligne ? Outre le droit à l'information et la suppression du CSAM - quelles mesures de soutien sont prévues pour les victimes et les survivants d'abus sexuels sur des enfants ?

Le COM pourrait-il donner des exemples de mesures d'atténuation possibles concernant la diffusion de CSAM ainsi que le grooming, qui permettent d'éviter une ordonnance de détection ?

La Commission pourrait-elle expliquer comment la vérification de l'âge par les fournisseurs ou les App Stores doit être conçue ? Quel type d'information doit être fourni par un utilisateur ? En ce qui concerne le "grooming", votre proposition vise spécifiquement la communication avec un enfant utilisateur. L'identification d'un enfant utilisateur doit-elle se faire uniquement par la vérification de l'âge ? Si un risque a été détecté, les fournisseurs seront-ils obligés de mettre en place un enregistrement des utilisateurs et une vérification de l'âge ? Y aura-t-il également une vérification pour identifier les utilisateurs adultes qui abusent des applications conçues pour les enfants ?

La Commission partage-t-elle l'avis selon lequel le considérant 26, qui indique que l'utilisation de la technologie de cryptage de bout en bout est un outil important pour garantir la sécurité et la confidentialité des communications des utilisateurs, signifie que les technologies utilisées pour détecter les abus commis sur les enfants ne doivent pas compromettre le cryptage de bout en bout ?

La COM pourrait-elle décrire en détail les technologies qui ne portent pas atteinte au cryptage de bout en bout, qui protègent l'équipement terminal et qui peuvent quand même détecter le CSAM ? Existe-t-il des limites techniques ou juridiques (existantes ou futures) à l'utilisation de technologies permettant de détecter les abus sexuels d'enfants en ligne ?

Quel type de mesures (technologiques) la COM estime-t-elle nécessaire pour les fournisseurs de services d'hébergement et les fournisseurs de communication interpersonnelle dans le cadre de l'évaluation des risques ? En particulier, comment un fournisseur peut-il procéder à une évaluation des risques sans appliquer les technologies visées aux articles 7 et 10 ? Comment ces fournisseurs peuvent-ils remplir l'obligation si leur service est crypté de bout en bout ?

Quel est le degré de maturité des technologies de pointe permettant d'éviter les faux positifs ? Quelle est la proportion de faux positifs à laquelle on peut s'attendre lorsque des technologies sont utilisées pour détecter le grooming ? Afin de réduire le nombre de résultats faussement positifs, la COM estime-t-elle nécessaire de stipuler que les résultats ne sont divulgués que si la méthode répond à certains paramètres (par exemple, une probabilité de 99,9% que le contenu en question soit approprié) ?

La proposition établit-elle une base juridique pour le traitement des données à caractère personnel des prestataires dans le cadre d'un ordre de détection au sens de l'article 6 du GDPR ? La proposition établit-elle une base juridique pour le traitement des données à caractère personnel pour l'EU-Centre dans le cadre d'un ordre de détection au sens du règlement 2018/1725 ?

En outre, nous aimerions déjà soulever les questions suivantes :

L'évaluation des risques et l'atténuation des risques :

La COM peut-elle détailler les " échantillons de données " pertinents et la portée pratique des obligations d'évaluation des risques ? En particulier, la distinction entre les fournisseurs de services d'hébergement et les fournisseurs de services de communication interpersonnelle.

La COM peut-elle confirmer que la recherche volontaire de CSAM par les fournisseurs reste (légalement) possible ? Est-il prévu d'étendre le règlement provisoire qui permet aux fournisseurs de rechercher des CSAM ?

Dans l'Art. 3 par. 2 (e) ii, la proposition décrit des caractéristiques qui sont typiques des plateformes de médias sociaux. Le COM peut-il décrire des scénarios dans lesquels, pour ces plateformes, une analyse de risque n'aboutit pas à un résultat positif ?

Concernant les injonctions de détection :

Le considérant 23 indique que les ordres de détection devraient - si possible - être limités à une partie identifiable du service, par exemple à des utilisateurs ou groupes d'utilisateurs spécifiques. La COM pourrait-elle préciser comment les utilisateurs/groupes d'utilisateurs spécifiques doivent être identifiés et dans quels scénarios un ordre de détection ne devrait être émis que pour un utilisateur/groupe d'utilisateurs spécifique ?

Les exigences énoncées à l'article 7, paragraphes 5, 6 et 7 doivent-elles être comprises de manière cumulative ?

La COM peut-elle clarifier la notion de "preuve d'un risque significatif" ? Est-il suffisant qu'il y ait plus d'utilisateurs enfants sur les plateformes et qu'ils communiquent dans la mesure décrite à l'article 3 ?

Dans quelle mesure l'ordre de détection précise-t-il la mesure technique exigée du fournisseur ?

La COM peut-elle clarifier les exigences des paragraphes 5b, 6a, 7b - quelle norme de contrôle est appliquée ? Comment la probabilité de l'Art. 7, paragraphe 7 (b) ? Le principe in dubio pro reo s'applique-t-il en faveur du service d'hébergement ?

Comment les motifs de l'émission de l'ordre d'identification sont-ils mis en balance avec les droits et les intérêts légitimes de toutes les parties concernées en vertu de l'article 7, paragraphe 4, point b) ? Est-ce basé sur une mesure concrète ou abstraite ?

La COM a-t-elle déjà reçu un retour d'information de la part des prestataires, notamment en ce qui concerne l'article 7 ? Dans l'affirmative, pouvez-vous préciser le feedback général ?

Dans quelle mesure l'ordre d'identification précise-t-il concrètement la mesure exigée du prestataire ? Qu'est-ce qui découle à cet égard de l'article 7, paragraphe 8 ("vise et précise [l'ordre de détection]"), et de l'article 10, paragraphe 2 ("Le prestataire n'est pas tenu d'utiliser une technologie spécifique") ?

À la page 10 de la proposition, on peut lire : "Il est préférable d'imposer des obligations de détection des abus sexuels en ligne à l'égard des enfants plutôt que de dépendre d'actions volontaires de la part des fournisseurs, et ce non seulement parce que ces actions se sont jusqu'à présent révélées insuffisantes pour lutter efficacement contre les abus sexuels en ligne à l'égard des enfants (...)". Quelles sont les preuves apportées par la COM qui prouvent que ces options volontaires sont insuffisantes ?

Comment le projet de règlement se rapporte-t-il aux droits des personnes concernées en vertu des art. 12 et suivants du GDPR, en particulier l'article 22 GDPR ?

En ce qui concerne les tâches existantes des autorités de contrôle de la protection des données en vertu du GDPR et d'autres actes européens existants ou en cours de négociation (tels que l'ASD), comment peut-on parvenir à un contrôle efficace des ordres d'identification ?

Est-ce que "toutes les parties concernées" dans l'art. 9 inclut-il les utilisateurs qui ont diffusé des MSC ou sollicité des enfants mais qui ont néanmoins été contrôlés ?

Technologies

Quelles technologies peuvent être utilisées en principe ? Microsoft Photo ID répond-elle aux exigences ?

Les technologies utilisées en relation avec les services en nuage doivent-elles également permettre l'accès aux contenus cryptés ?

Comment la qualité des technologies est-elle assurée ou validée ? Comment la proposition de la CSA s'articule-t-elle avec le projet de loi sur l'IA ?

Comment l'équivalence des technologies propres aux fournisseurs doit-elle être évaluée en vertu de l'article 10, paragraphe 2, et comment cela se rapporte-t-il à la capacité des fournisseurs d'invoquer des secrets commerciaux ?

La technologie peut-elle être conçue pour faire la différence entre des photos d'enfants dans un cadre normal/non abusif (par exemple à la plage) et des MSCA ?

Un logiciel d'analyse de texte peut-il faire la différence entre une conversation légitime entre des adultes (parents, proches, enseignants, entraîneurs sportifs, amis, etc.) et des enfants et une situation de toilettage ?

Comment voulez-vous vous assurer que les fournisseurs utilisent uniquement la technologie - notamment celle proposée par le Centre européen - pour exécuter l'ordre de détection ?

Comment gérer une erreur ? Comment détecter d'éventuels cas d'utilisation abusive ?

Pourriez-vous donner des précisions sur la surveillance humaine et sur la manière dont elle peut prévenir les erreurs commises par les technologies utilisées ?

Comment voulez-vous que les fournisseurs informent les utilisateurs de "l'impact sur la confidentialité des communications des utilisateurs" ? S'agit-il d'une obligation due à l'émission d'une injonction de détection ? Ou cela peut-il faire partie des conditions générales ?

Les fournisseurs d'hébergement de fichiers ou d'images, qui n'ont pas accès au contenu qu'ils stockent, entrent-ils dans le champ d'application du règlement ?

Autres obligations des fournisseurs

Comment les obligations de déclaration prévues par la présente proposition s'articulent-elles avec les déclarations actuelles du NCMEC ? Comment les deux processus peuvent-ils être rationalisés au mieux ? Comment peut-on s'assurer qu'il n'y a ni duplication ni perte de rapports ?

Quel rôle l'autorité de coordination devrait-elle jouer en ce qui concerne l'obligation de déclaration ?

En ce qui concerne la suppression du CSAM à l'échelle de l'UE, comment la Commission traite-t-elle les différences nationales en matière de droit pénal ?

Quel est le nombre de cas que la COM prévoit pour les rapports au CSA de l'UE ? Combien de cas seront transmis aux autorités répressives nationales compétentes et/ou à Europol ?

Le droit à un recours effectif sera-t-il affecté par l'obligation prévue à l'art. 14 d'exécuter une mesure d'éloignement dans les 24 heures ?

A quel moment peut-on supposer que la connaissance du contenu a été obtenue par le fournisseur, la connaissance humaine est-elle requise ?

Quelle norme de contrôle la COM assume-t-elle à l'égard des différents "acteurs" de la chaîne d'information dans le processus d'émission d'une ordonnance ? Cela inclut-il l'exigence d'une évaluation/un audit humain dans chaque cas ?

Pourquoi Europol devrait-il être impliqué dans tous les cas, c'est-à-dire pas seulement dans les cas où la responsabilité des EM n'est pas claire ?

Comment les ordres de blocage peuvent-ils être limités en pratique à des contenus ou à des zones spécifiques d'un service, ou peut-on bloquer uniquement l'accès au service dans son ensemble ?

Les services en nuage doivent-ils bloquer l'accès au contenu crypté s'ils reçoivent un rapport d'activité suspecte concernant des utilisateurs spécifiques ?

Sanctions

Pourquoi avoir choisi une latitude d'appréciation en matière de sanctions ?

L'art. 35 s'applique-t-il aux cas d'utilisation abusive de la technologie ou à l'omission de mettre en place des mesures efficaces pour prévenir une telle utilisation abusive (article 10, paragraphe 4) ?

Pourquoi la proposition ne suit-elle pas les sanctions prévues par le règlement TCO ?

L'article 35, paragraphe 2, pourrait-il être limité aux violations d'une obligation centrale ou d'un petit nombre d'obligations centrales ?

Systèmes d'échange d'informations

L'article 39, paragraphe 2, ne prévoit pas que les autorités répressives nationales soient directement connectées aux systèmes d'échange d'informations. De quelle manière les rapports seront-ils transmis aux autorités répressives nationales ?

Que doit englober le système d'échange d'informations ? Comment concilier au mieux l'efficacité et la protection des données ?

Seuls le CSA de l'UE et Europol auront un accès direct à la base de données des indicateurs (Art 46(5)), comment les LEA nationales/autorités nationales de coordination peuvent-elles participer au mieux à l'information ? La Commission estime-t-elle qu'une nouvelle interface est nécessaire pour faire savoir aux autorités nationales que d'autres informations pourraient être disponibles ?

CSA de l'UE et Europol

En ce qui concerne la coopération proposée entre le Centre de l'UE et Europol, comment la Commission envisage-t-elle concrètement la répartition des tâches entre les deux entités afin d'éviter toute duplication des efforts ?

Nous avons remarqué que l'analyse d'impact de la Commission n'examine pas plus avant la possibilité d'intégrer les tâches de prévention et d'aide aux victimes dans la FRA et les tâches pertinentes pour la répression dans Europol au lieu de créer une nouvelle entité. Il semble plutôt que cette possibilité soit écartée après un examen préliminaire. Nous aimerions donc savoir pourquoi cette option n'a pas été examinée plus avant en premier lieu ? En outre, nous demandons à la COM d'expliquer les avantages qu'elle attend de la création d'une nouvelle entité plutôt que de l'attribution des tâches à la FRA et à Europol en combinaison ?

La proposition législative prévoit qu'Europol fournisse certains "services de soutien" au CSA de l'UE. Quels sont les moyens et services concrets auxquels le CSA de l'UE devrait faire appel à Europol ? Comment ces tâches de soutien peuvent-elles être distinguées des tâches de l'ASC de l'UE ? Dans ce contexte, nous aimerions demander si et si oui, combien de ressources supplémentaires COM estime pour Europol ?

Comment Europol devrait-il gérer ce soutien en termes de ressources et comment la COM garantit-elle que ce soutien ne se fera pas au détriment des autres tâches d'Europol ?

Comment la structure de gouvernance proposée pour le CSA de l'UE peut-elle être rationalisée au mieux avec la structure de gouvernance d'Europol en veillant à ne pas créer de déséquilibre entre la Commission et les États membres ?

L'article 53, paragraphe 2, du projet traite de l'accès mutuel aux informations et systèmes d'information pertinents en relation avec Europol. Avons-nous raison de supposer que cette disposition ne réglemente pas l'accès aux informations en tant que tel, puisqu'il est fait référence aux dispositions pertinentes ("conformément aux actes du droit de l'Union qui régissent cet accès") ? Quel est alors le contenu réglementaire spécifique de la disposition ? Veuillez expliquer.

Pour quelle période la COM estime-t-elle que le CSA de l'UE peut commencer son travail (tout en n'étant peut-être pas encore pleinement opérationnel) ?

À quel stade du processus les images sont-elles effacées selon la proposition ?

Selon l'article 64(4)(h), le directeur exécutif du CSA de l'UE à créer peut imposer des sanctions financières en cas d'actes criminels portant atteinte aux ressources financières de l'Union. Comment cela se rapporte-t-il aux procédures de l'OEPP ?

Comment la proposition peut-elle garantir que les compétences du CSA de l'UE n'entrent pas en conflit avec les compétences d'Eurojust ?