Rotten Apples: iOS 15、個人のプライバシー、そしてCSAMとの継続的な戦い。

"iOS 15 In touch.In the moment."

今回のOSアップデートでは、アップル社によると「コミュニケーションツールを利用して子どもを勧誘・搾取する略奪者から子どもを保護し、児童性的虐待資料(CSAM)の拡散を抑制する」ための3つの新機能が追加されるようです。 1つ目は「メッセージでのコミュニケーションの安全性」の向上を目的としたもので、新たなペアレンタルコントロールツールと、性的に露骨な内容が送受信された際に表示される警告が追加されます。2つ目は、CSAM検出アルゴリズムを使用して「写真」アプリをスキャンし、既知のCSAMハッシュに一致する画像ハッシュを検出する機能です。3つ目の児童保護の新機能は、検索の「ガイダンス」で、CSAMを報告するためのリソースをユーザーに提供し、ユーザーがCSAMに関連する用語を検索した場合には積極的に介入します。それでは、これらの機能が何を目的とし、どのように機能するのか、詳細を説明します。

未承諾のチンコ写真はもういらない。

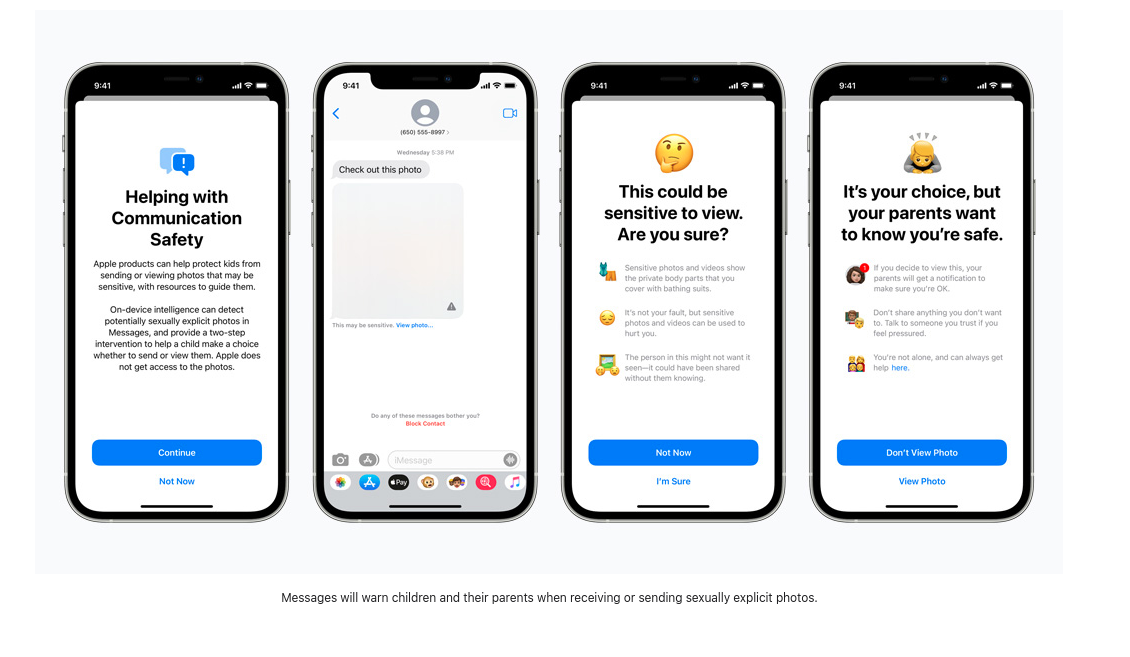

ソーン社の最近の研究によると、「自分で作成した児童性的虐待資料(SG-CSAM)は、オンラインで流通している児童性的虐待資料(CSAM)の中で急速に増加している分野であり、虐待者のコミュニティによって消費されている」と報告されています。アップル社の新しい「子供のための保護機能の拡大」は、この行為の増加を遅らせることを目的としています。恋愛関係にあるパートナーの間で「ヌード」を共有することは、しばしば仲間内で広まり、「リベンジポルノ」のケースではネット上に出回ることがあります。アップルは今後、子どもたち(またはこれらの安全機能を有効にしているユーザー)に対して、露骨な画像の閲覧や送信に関する警告を表示します。画像が閲覧または送信された場合、親のデバイスにはその行為に関する通知メッセージが表示されます。

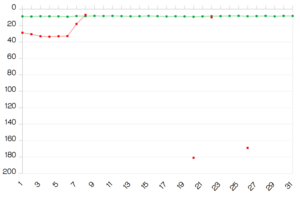

受信した画像は、デバイス上の機械学習プログラムによってスキャンされ、疑わしい素材にフラグを立て、今後の画像が同じカテゴリーに入るかどうかを「学習」します。このアルゴリズムを誰が制御しているのか、また、疑わしい画像の報告方法にユーザーがどのような影響を与えることができるのかは、まだ公表されていません。アップルは、「この機能は、アップルがメッセージにアクセスできないように設計されています」と書いていますが、この新しいアップデートにより、アップルはiMessageで送信された暗号化されたメッセージのスクリーニングを開始し、オンラインでの有害な行為について親や十代の若者に警告することになります。

表面的には危険ではないように見えますが、もしこの同じスキャン技術を使って、反対の政治的意見や少数派の宗教的言語、性的指向に関する議論などの暗号化されたメッセージをスキャンした場合、この新しいデバイス上の監視ソフトウェアは簡単に変更され、悪用される可能性があります。

** https://www.apple.com/child-safety/**の警告メッセージのいくつかのサンプルです。

** https://www.apple.com/child-safety/**の警告メッセージのいくつかのサンプルです。

拡散防止のためのスキャン

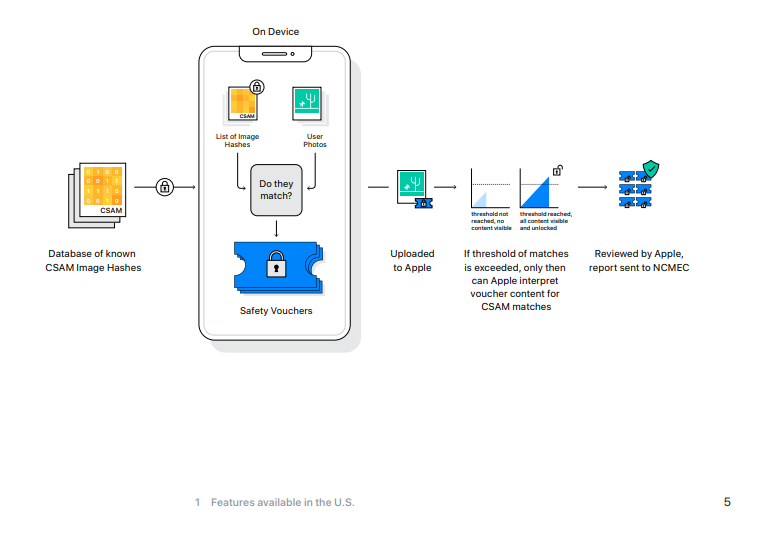

電子フロンティア財団によると、「Appleは、iCloud Photosに保存されている写真を閲覧するための鍵を持っているが、これらの画像をスキャンしていない」とのことです。これはiOS 15で変更され、現在AppleのiCloudに写真をバックアップしている場合、これらの写真はハッシュ化され、その値は既知のCSAMの値と比較されます。

iOSデバイスがiCloudのバックアップ機能を有効にしている場合、このスキャンはまずローカルマシンで開始されます。新しいiOS 15には、National Center for Missing and Exploited Children's CSAMのハッシュ化された画像データベースのバージョンが搭載されており、iPhoneで撮影された暗号化されていない画像は、そのハッシュ(画像を表す*希望的観測値)がNCMECのデータベースのものと比較されます。一致した場合、写真はアップル社の人間の審査員に送られます。これらの審査員が一致を確認した場合、画像はNCMECと法執行機関に送られ、ユーザーのアカウントは無効化されます。

あなたがiCloudを使って写真をバックアップしている場合、あなたが何らかの犯罪を犯した、あるいは関与しているという相当な理由や疑いがなくても、あなたの写真はこのデータベースに対してスキャンされます。

[この写真を[見ないで]ください。

子どもの安全に関する最後の新機能は、Siriと検索のアップデートで、CSAMの事例を報告する方法のガイダンスを提供するとともに、ユーザーがCSAMに関連する用語を検索している場合に「介入」することができるようになります。

正確なワードリストは公開されておらず、ユーザーが報告した用語が機械学習による検索モニターのトレーニングに使用されるかどうかもわかりません。

また、どのような用語がこれらの警告を引き起こすのか、警告を無視した場合に何が起こるのかについては、ほとんど情報がありません。画像のハッシュ化審査の場合、アップルの従業員が一致する結果を判断しますが、検索結果に対してさらにどのような措置が取られるかはわかりません。これらの新機能に関するアップルの公式プレスページを見ると、監視対象となる検索語についての説明は4つの短い文章で構成されています。このリストが、ユーザーから報告された用語に基づいて増えていくのか、あるいはアップルがこのアルゴリズムをどのように訓練するのか、興味深いところである。

隠すことがなければ...

これらの3つの新機能により、Appleのユーザーや、彼らとメッセージや写真を送る人たちは、暗号化されたメッセージのスキャンや、プライベートな検索語の監視を受けることになります。Appleやその他のビッグテック企業が、自社のサーバーに保存されている画像のハッシュをスキャンすることは、一つのことです。結局、これらのサーバーは会社の資産であり、利用する必要はありません。しかし、これらの新しい監視機能をローカルデバイスに押し付けることは、デバイスの所有者であるあなたが、あなたの行動を監視するデバイスに何百ドル(またはユーロ)も支払っているという事実を無視しています。自分の個人的な財産の一部をどのようなプロセスで動かすかについては、あまり選択の余地はありません。この「改良」は、プロプライエタリなソフトウェアの世界ではすでに主流となっている「Product-as-Service」モデルにさらに近づいています。

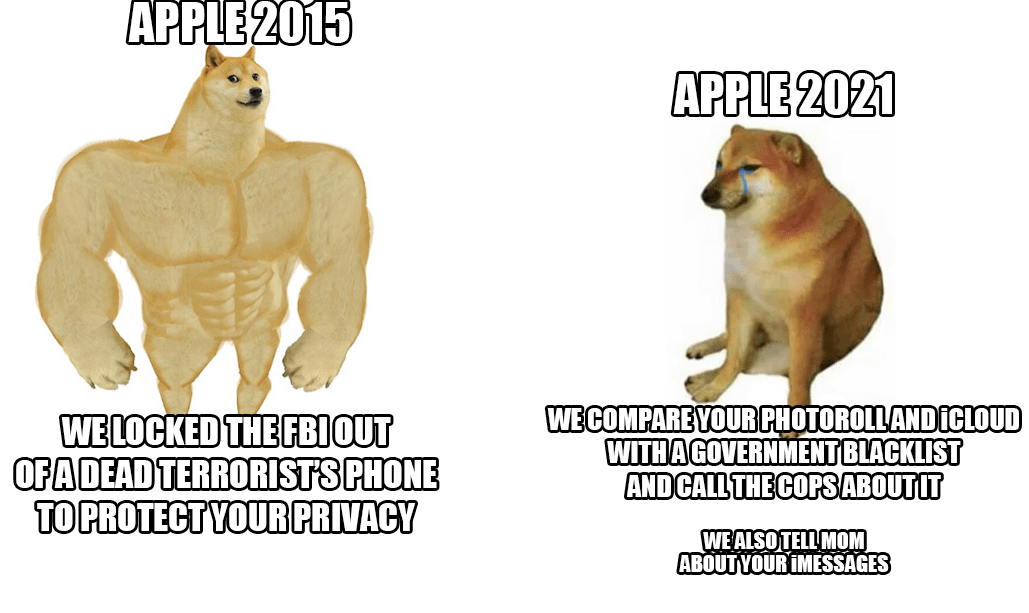

今回のiOSの新バージョンでは、アップル社は、かつて賞賛されたメッセージングプラットフォームのセキュリティを弱めています。エンド・ツー・エンドで暗号化されたメッセージングアプリが、送信先のデバイスに届いた時点で画像をスキャンするというのは、Appleユーザーのセキュリティとプライバシーを守るためには何の役にも立たない危険な嘘です。このような行為が、人権を尊重しない国家によってどのように適用されるかは、災いのもとです。

エドワード・スノーデンは、2021年8月6日のツイートで、アップルの奇妙な進化を指摘しています。

エドワード・スノーデンは、2021年8月6日のツイートで、アップルの奇妙な進化を指摘しています。

IOS 15は、エンドツーエンドの暗号化の将来について、危険な基準を設定しています。

子どもたちを守ることが、監視の強化と個人のプライバシーの溶解の世界へと導くマントラとなるでしょう。しかし、CSAMの存在は、プライバシー、データ暗号化、性的暴力、監視をめぐる微妙な議論を放棄する理由にはなりません」と述べています。

マシュー・グリーンは、これらの変更の余波について次のように警告しています。「Appleの長期的な計画がどうなっているかにかかわらず、彼らは非常に明確なシグナルを送っています。彼ら(非常に影響力のある)の意見では、ユーザーの携帯電話をスキャンして禁止されたコンテンツを探すシステムを構築することは安全だということです。これは、政府、競合サービス、中国、そしてあなたに送っているメッセージなのです」。